Poezja bez ryzyka to tylko składnia: dlaczego ChatGPT nie sprawdzi się w tworzeniu poezji

Względnie wysoka jakość dużych modeli językowych w generowaniu logicznego i spójnego tekstu okazuje się argumentem przeciwko wykorzystywaniu ich w pracy nad poezją.

Olga Vechtomova w pracy Between Predictability and Randomness: Seeking Artistic Inspiration from AI Generative Models (DOI: 10.48550/arXiv.2506.12634, 2025) porównuje dwie ścieżki maszynowego wsparcia dla pracy nad tekstami poetyckimi. Na szczęście nie ma w jej tekście niepotrzebnych nam pytań o to, kto jest poetą (bo nie wiadomo) i czy sztuczna inteligencja może być kreatywna (nie może, chyba że mówimy o kreatywności względnej, vide DOI: 10.48550/arXiv.2401.01623, 2024). Zamiast tego ta kanadyjska badaczka z Uniwersytetu Waterloo dokładnie wskazuje przestrzeń, w której maszynowe rozwiązania oparte o prawdopodobieństwo mogą być użyteczne w pisaniu poezji. Co to za przestrzeń, hm?

Autorka wykorzystuje schemat pracy kreatywnej, zaproponowany przez Ricka Rubina w The creative act: a way of being (2023). Proces twórczy, bez względu na to, czy piszemy poezję, malujemy albo komponujemy, składać się ma z następujących etapów:

Faza ziarna (seed phase) - jak pisze Vechtomova, to stan kreatywnej podatności, w którym różne bodźce mogą wywołać jakąś artystyczną inspirację. To etap zwiększonej wrażliwość na sygnały językowe (słowa, frazy, struktury składniowe), stan otwartości na nieoczekiwane skojarzenia i podążanie za niejednoznacznymi inspiracjami, które mogą być źródłem bardzo różnych interpretacji.

Faza eksperymentowania (experimentation) jest stanem czy procesem łączenia ze sobą przez autora / autorkę poszczególnych elementów rozpoznanych i odkrytych w fazie ziarna. Według Vechtomovej, surowe elementy zgromadzone podczas fazy ziarna, w fazie eksperymentowania nabierają spójnej formy.

Tworzenie (crafting). Na tym etapie procesu twórczego człowiek wykorzystuje swoje umiejętności techniczne i osąd artystyczny, tak aby dopracować ostateczny efekt.

Zdaniem autorki, to w fazie ziarna w procesie tworzenia poezji szukać moglibyśmy maszynowego i losowego wsparcia. To odniesienie do losowości jest kluczowe, ponieważ pozwala Vechtomovej przytoczyć znane zjawiska i twórców z historii literatury: od dadaizmu (Kurt Schwitters i eksperymentalna technika Merzkunst) poprzez poezję lingwistyczną (Bob Perelman) aż po teksty Cobaina i Bowiego.

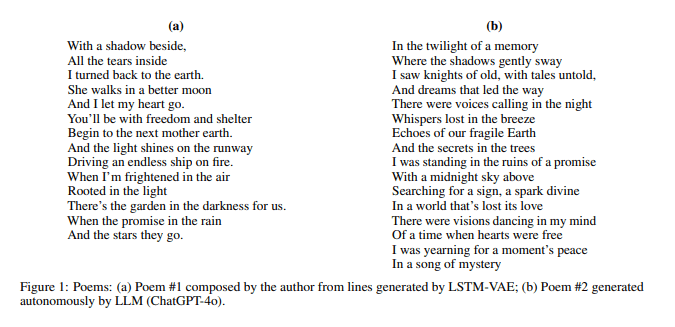

Oto potrzebować mamy językowej i koncepcyjnej losowości na pierwszym etapie pracy nad wierszem i dziś pozyskać ją z modeli językowych. Olga Vechtomova przetestowała dwa z nich, różniące się znacznie parametrami.

Pierwszym był model z rodzaju LSTM-VAE, czyli zestawienia sieci neuronowej typu Long Short-Term Memory (LSTM) z autoenkoderem wariacyjnym (VAE). Uh, nie będę udawał, że potrafię dobrze wyjaśnić budowę tego zestawu, w każdym razie jego cechą jest to, że nie wymaga ogromnych ilości danych treningowych do uzyskania interesujących efektów w generowaniu języka naturalnego. Jak pisze Vechtomova, rozwiązanie to pozwala uchwycić podstawowe cechy zdań i można go trenować na mniejszych, starannie dobranych zbiorach danych, co ma dawać większą kontrolę nad stylem i treścią generowanego tekstu. Ograniczeniem LSTM-VAE jest to, że trudno nim generować długie ciągi tekstu. LSTM-VAE wykorzystywano do generowania tekstów czy muzyki jeszcze przed pojawieniem się dużych modeli językowych.

Drugim rozwiązaniem wybranym do testu poetyckiego był LLM - ChatGPT-4o. Jak wiadomo, modele tego rodzaju trenowane są na olbrzymich zestawach danych, a ich zastosowania są uniwersalne i korzystają z jakości, z jaką generują one nawet obszerne fragmenty tekstów.

Autorka wyjaśnia dalej, że

Modele LSTM-VAE wprowadzają losowość poprzez próbkowanie z przestrzeni latentnej [gdzie teksty reprezentowane są w uproszczonej postaci wektorowej - MW], co prowadzi do generowania językowo nowych zdań, zdolnych zakłócić utarte schematy językowe i pobudzić kreatywność. Modele LLM również zawierają element losowości podczas wybierania kolejnego tokenu, który jest kontrolowany przez parametr temperatury. Wyższe wartości temperatury zwiększają prawdopodobieństwo wyboru mniej typowych słów, natomiast niższe wartości sprawiają, że model staje się bardziej zachowawczy. Jednak ta losowość jest ograniczona, ponieważ model wybiera tylko spośród tokenów o najwyższych prawdopodobieństwach w danej pozycji.

LSTM-VAE to rozwiązanie mniej przemysłowe i mniej uniwersalne niż LLM. Nie wiem, czy różnicę między nimi dobrze odda porównanie domowego zbioru VHSów z Netflixem albo - spoglądając na polskie pole literackie, wydawnictw ArtRage i Znak (może nie odda, ale nie mogłem się powstrzymać).

Uważam, że modele LSTM-VAE są bardziej odpowiednie do generowania bodźców językowych, które równoważą losowość i przewidywalność, co sprawia, że stają się skutecznym narzędziem w fazie ziarna (seed) procesu twórczego

pisze Olga Vechtomova. Cechami propozycji generowanych przez LSTM-VAE i następnie wykorzystanych przez badaczkę do konstrukcji wiersza są:

- semantyczna otwartość - wersy często zawierają celową niekompletność lub dwuznaczności, które zachęcają do ich uzupełnienia lub rozwinięcia zgodnie z wolą i wyobraźnią twórcy,

- niedosłowne wyrażanie stanów emocjonalnych - frazy takie jak "when I’m frightened in the air", "and I let my heart go", "she walks in a better moon" nie są może szczytem awangardy poetyckiej, przynajmniej jednak nie opisują emocji w dosłowny i nudny sposób,

- nieoczywiste zestawienia - frazy takie jak “driving an endless ship on fire” czy “rooted in the light” podważają konwencjonalne skojarzenia, są jednak wciąż sugestywne i emocjonalne,

- syntaktyczne wyobcowanie i niekompletność - wersy generowane przez LSTM-VAE są celowo niekompletne i semantycznie niedomknięte, np. "when the promise in the rain" czy "and the stars they go", pozwalając na nowe interpretacje i gry z wyobrażeniami,

- niegramatyczność - pozorne „błędy” (jak podwójny podmiot w „the stars they go”) pełnią funkcję poetycką: spowalniają percepcję i zmuszają do nowego zaangażowania w język. Autorka podkreśla, że działa tu ona podobnie jak “ostranenie" u Wiktora Szkłowskiego. Sprawiają, że to, co stare i znane, staje się nowym, w efekcie wyostrza postrzeganie frazy i otwiera ją nowe sposoby rozumienia.

Tymczasem LLMy jako wsparcie literackie oferują nam składniowe i semantyczne domknięcie, np. "where the shadows gently sway" (oczywistość i nuda), większą dosłowność i jednoznaczność, zazwyczaj konwencjonalne obrazy i toposy ("with a midnight sky above"), spójność narracyjną ("searching for a sign, a spark divine") i oczywiste środki poetyckie (metafora, regularny rytm, hiperbola), np. "twilight of a memory" czy "tales untold".

Szukając maszynowego wsparcia kreatywnego w pracy literackiej powinniśmy - jak przekonuje Vechtomova - mniej skupiać się na tradycyjnych miarach jakości poetyckiej (czy językowej w ogóle), a bardziej na generowaniu fraz z tej “najbardziej płodnej przestrzeni” (fertile middle ground) między kreatywną przypadkowością, a przewidywalnością, która pozwala w podstawowym stopniu odwzorować język naturalny.

Wygląda na to, że wartość literacka modeli językowych leży w dostępie do błędów, przypadku i niestandardowych połączeń niż w językowej doskonałości i olbrzymiego zasobu słów.

Autor: redakcja