Afera wokół książki Karoliny Opolskiej powinna przypomnieć o ograniczeniach ChatGPT w gromadzeniu i analizie literatury przedmiotu. Również w wielu artykułach polskich badaczy, dostępnych w Google Scholar, łatwo znaleźć ślady podobnego wykorzystania tego narzędzia, chociaż badania wyraźnie wskazują na niską jakość udostępnianych tam wyników wyszukiwania....

Czytaj dalejTekst wygenerowany przez model językowy, dostrojony na twórczości znanego autora, bardziej podoba się czytelnikom (ekspertom i amatorom) niż proza w jego stylu, napisana przez zawodowych pisarzy. Co więcej, jest niewykrywalny dla detektorów AI, nie powtarza dosłownych schematów z oryginalnych utworów, a jego wytworzenie kosztuje 99.7 proc. mniej niż potencjalne honorarium profesjonalnego pisarza, który miałby przygotować powieść w stylu oryginalnych twórców....

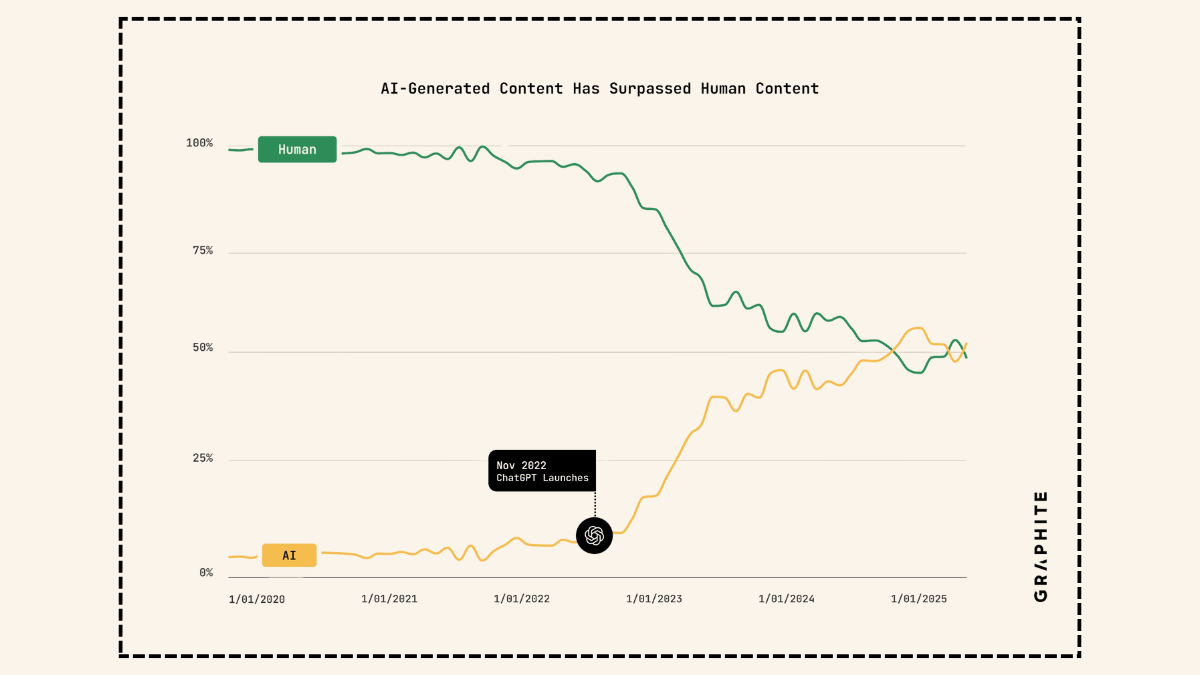

Czytaj dalejRaport firmy Graphite, zajmującej się optymalizacją treści stron pod wyszukiwarki (SEO), przekonuje, że większą część zasobów internetu stanowią już treści generowane maszynowo. Czy można wierzyć temu badaniu i czy jest się czego bać?...

Czytaj dalejSpodziewamy się, że duże modele językowe będą użytecznym wsparciem w tworzeniu opisów zabytków, tłumaczeniu starożytnych tekstów czy rozwijaniu zasobów edukacyjnych. Podjęty niedawno test pięciu modeli open-source na 1066 niepowtarzalnych zadaniach ujawnia jednak poważne ograniczenia. Ponad 65 proc. wygenerowanych odpowiedzi zawiera istotne niezgodności kulturowe (cultural value misalignment)....

Czytaj dalejCzy fikcje w całości generowane przez duże modele językowe mogą nawiązywać do tradycji narodowych i uwzględniać rzeczywistość poszczególnych krajów? Aby to sprawdzić, badacze z Uniwersytetu w Bergen wygenerowali i przeanalizowali niemal 12 tys. opowiadań, przedstawiających historie dla 236 krajów, w tym dla Polski....

Czytaj dalejZaproponowany przez Google system znaków wodnych SynthID nie jest jeszcze standardem, ale udowadnia, że bez widocznej zmiany w przekazie tekstu można zapisać w nim informację o tym, że został wygenerowany przez sztuczną inteligencję. Czy tak podpisane teksty będzie można wykrywać w ramach polityki antyplagiatowej na uczelniach czy w wydawnictwach?...

Czytaj dalejGenerative AI Delegation Taxonomy (GAIDeT) to zbiór reguł, który pozwala w zwięzły sposób podsumować, w jaki sposób wykorzystano narzędzia generatywnej sztucznej inteligencji w pracy nad tekstem naukowym. Czy może to być inspiracja do powstania systemu oznaczania tekstów literackich i dziennikarskich, umożliwiającego przejrzyste raportowanie użycia AI w procesie twórczym i redakcji?...

Czytaj dalejDuża część detektorów, mających sprawdzać, czy dany tekst został wygenerowany przez LLM, bazuje na perpleksji. W konsekwencji, jeśli nie mamy naturalnie bogatego słownictwa, albo materia pracy pisemnej wymaga prostego języka, przygotowany przez nas tekst może zostać fałszywie oznaczony. Z tego powodu lepiej ręcznie starać się rozpoznawać generowane teksty. Metody takiego sprawdzania, użyteczne na przykład podczas oceny studenckich prac pisemnych, sugeruje społeczność Wikipedii....

Czytaj dalejWzględnie wysoka jakość dużych modeli językowych w generowaniu logicznego i spójnego tekstu okazuje się argumentem przeciwko wykorzystywaniu ich w pracy nad poezją....

Czytaj dalejCzy tego chcemy, czy nie, maszynowe generowanie tekstu jest już na tym poziomie, że może z powodzeniem imitować literaturę. A skoro tak, to potrzebne są narzędzia, aby taką generatywną literaturę skutecznie oceniać....

Czytaj dalej