Taksonomia GAIDeT: Jak raportować użycie sztucznej inteligencji w pisaniu

Generative AI Delegation Taxonomy (GAIDeT) to zbiór reguł, który pozwala w zwięzły sposób podsumować, w jaki sposób wykorzystano narzędzia generatywnej sztucznej inteligencji w pracy nad tekstem naukowym. Czy może to być inspiracja do powstania systemu oznaczania tekstów literackich i dziennikarskich, umożliwiającego przejrzyste raportowanie użycia AI w procesie twórczym i redakcji?

Możemy różnie oceniać wykorzystanie AI w pracy nad tekstami naukowymi, w literaturze czy dziennikarstwie, ale łączy nas pewnie potrzeba odpowiedniej przejrzystości tego użycia. Z pewnością da się racjonalnie i zgodnie ze sztuką wykorzystać AI do proofreadingu tekstu naukowego czy stworzenia propozycji abstraktów i tytułów, być może nawet można ją wykorzystać do zaproponowania tematu badania. Lektura i ocenianie takiego tekstu musi jednak być podparte wiedzą o tym, jakie narzędzia zostały wykorzystane, w jakim celu i w jakich zadaniach. Podobnie rzecz ma się z tekstami literackimi i dziennikarskimi. Jeśli korzystasz z AI i akceptujesz jakość ostatecznego efektu, nie ma w tym nic złego, pod warunkiem, że wszyscy będą wiedzieć, że ten tekst powstał przy wsparciu maszynowym.

Pożytki z taksonomii

Jednak jak o tym poprawnie informować? Yana Suchikova i współautorzy w tekście GAIDeT (Generative AI Delegation Taxonomy): A taxonomy for humans to delegate tasks to generative artificial intelligence in scientific research and publishing (10.1080/08989621.2025.2544331, 2025) proponują specjalną taksonomię, za pomocą której w przejrzysty sposób opisać można użycie AI w przygotowywaniu tekstu naukowego.

Taksonomia to system klasyfikacji, który pomaga uporządkować wiedzę za pomocą grupowania powiązanych ze sobą pojęć. Przykładowo, klasyczna taksonomia Linneusza porządkuje wiedzę o gatunkach roślin i zwierząt oraz kształtuje określony porządek między poszczególnymi gatunkami. Wywodzące się z tradycji chrześcijańskiej siedem grzechów głównych czy buddyjskie kleśa to także taksonomie, tym razem opisujące rzeczywistość moralną czy duchowość. Powszechnie stosowane na blogach taksonomie wykorzystują kategorie i tagi, którymi można opisywać poszczególne notki.

Budowanie własnych taksonomii ma sens nawet w samodzielnej pracy (na przykład dzielenie przeglądanej literatury na źródła czy opracowania), jednak doskonale sprawdza się też jako standard. Historia międzynarodowego kodeksu nomenklatury botanicznej jest opowieścią o ujednolicaniu systemu nazewnictwa roślin, który dziś ustala zasady tworzenia nazw naukowych. Siedem grzechów głównych czy kleśa, znane powszechnie i zrozumiałe dla wierzących, mogą być podstawą nauk moralnych czy ćwiczeń duchowych - we wszystkich tych praktykach odwoływać się można do wspólnego rozumienia pewnych spraw. Creative Commons to nie tylko system licencji, ale też pewnego rodzaju taksonomia zarządzania prawami autorskimi, która znacznie ułatwia licencjonowanie treści online. Oczywiście taksonomie, normy i standardy to rzecz przydatna nie tylko w wymiarze twórczym - w XIX wieku Joseph Whitworth wypracował standard gwintów śrubowych, który znacznie przyspieszył rozwój kolei na Wyspach Brytyjskich.

Generative AI Delegation Taxonomy (GAIDeT)

W redakcji tekstów naukowych istnieją już taksonomie, pozwalające opisać relacje autorów (twórców) z tekstem czy wykorzystanie rozwiązań AI w pracy naukowej. Twórcy omawianego artykułu przywołują kilka istniejących już taksonomii, takich jak CRediT, NIST AI 200-1 czy propozycję Khalifa i Albadawy (10.1016/j.cmpbup.2024.100145, 2024).

Według twórców GAIDeT propozycje te nie są jednak wystarczające, ponieważ nie pozwalają na dobre opisanie zaawansowanych sposobów wykorzystania sztucznej inteligencji w pracy naukowej. Przykładowo, standard CRediT (Contributor Roles Taxonomy) nie pozwala w ogóle na opisanie wkładu AI oraz nie uwzględnia statusu prawnego treści generowanych maszynowo, jest też zbyt ogólny. Taksonomia NIST nie uwzględnia faktu, że AI wykorzystywana jest w nauce na określonych etapach prowadzenia badań czy pisania tekstu. Stąd nowa propozycja klasyfikacji opisującej to, jakie zadania badawcze czy redakcyjne delegowano na narzędzia sztucznej inteligencji na kolejnych etapach pracy naukowej.

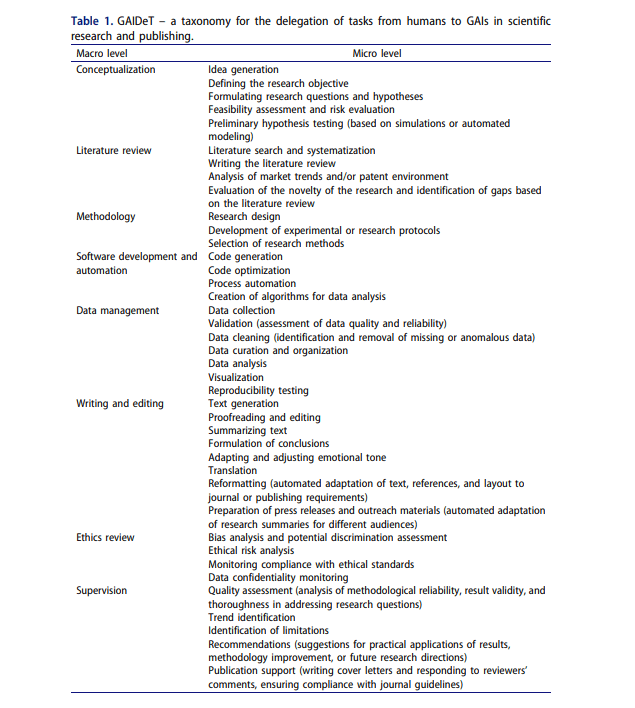

W klasyfikacji GAIDeT użycia AI deklaruje się w skali makro i mikro. Kategorie poziomu makro opisują cały proces badawczy - od wypracowywania koncepcji badania po redagowanie tekstu. Kategorie mikro to szczegółowe wskazania konkretnych zadań, które udało się zrealizować dzięki AI, np. "zdefiniowanie obiektu badania", "czyszczenie danych" czy "tłumaczenie tekstu". Autor czy autorka korzystająca z GAIDeT może opisać wyłącznie te przestrzenie pracy nad tekstem, w których użyła AI, bez konieczności tworzenia ogólnych i niejasnych deklaracji. Strukturę tej taksonomii przetestować można sobie wypełniając formularz.

Warto zwrócić uwagę, że częścią taksonomii jest kategoryzacja ograniczeń i zagrożeń związanych z AI. Dzięki temu w czytelny sposób poinformować można odbiorców o ewentualnej stronniczości zastosowanych modeli czy określonych wyzwaniach etycznych.

Ujawnianie użycia AI w tekstach literackich i dziennikarstwie

Już dziś w polu literackim czy przestrzeni mediów mamy problem z niejawnym wykorzystaniem AI w pracy redakcyjnej. Mamy też przykłady z Polski. W kwietniu tego roku na stronach Onetu pojawił się artykuł z halucynowaną bibliografią, w sierpniu pojawiły się kontrowersje w związku z wykorzystaniem przez wydawnictwo Zielona Sowa maszynowo generowanych grafik, przedstawianych jako produkcje autorskie.

Generatywną AI z powodzeniem wykorzystać można przy pracy nad tekstem, na przykład do wstępnej redakcji, wykrywania błędów logicznych albo wyszukiwania synonimów. Zasadne jest pytanie, czy takie ograniczone użycie należy raportować, skoro nikt nie raportuje korzystania np. z autokorekty edytora Word. Na pewno jednak jakakolwiek istotniejsza ingerencja narzędzi AI w kształt tekstu powinna być ujawniona. Czy dałoby się do tego zastosować GAIDeT?

Ze względu na to, że taksonomia ta dostosowana jest do specyfiki tekstów naukowych, należałoby ją odpowiednio przetworzyć, modyfikując poziomy makro i ich szczegółowe rozwinięcia. Być może to zadanie dla organizacji takich jak Unia Literacka czy dziennikarskie organizacje branżowe.

Oczywiście organizacje te mogą również z góry odrzucić prawomocność jakiejkolwiek ingerencji AI w proces pisania i redakcji. Rada Pisarzy Europejskich (EWC), Europejska Rada Stowarzyszeń Tłumaczy Literackich (CEATL) oraz Federacja Wydawców Europejskich (FEP) wystosowały niedawno apel do Komisji Europejskiej, którego jednym z postulatów jest

opracowanie trwałego mechanizmu pozwalającego na łatwe rozpoznawanie produktów generowanych przez sztuczną inteligencję, które wyglądają jak książki i przez to mogą wprowadzać opinię publiczną w błąd, opartego na jasno określonych powinnościach [osób wykorzystujących AI - przyp. MW], dla lepszej ochrony konsumentów, czytelników, autorów oraz innych podmiotów praw autorskich.

Jak można ujawniać użycie AI?

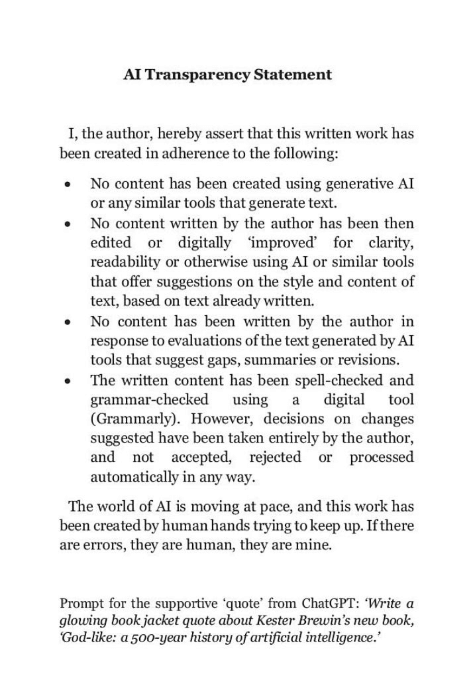

Kester Brewin, autor książek non-fiction, w wydanej w zeszłym roku God-Like: A 500-Year History of Artificial Intelligence in Myths, Machines, Monsters umieścił oświadczenie o wykorzystaniu AI.

W tekście w Guardianie przedstawił swoją motywację dla takiego kroku:

Dopóki nie powstanie mechanizm pozwalający sprawdzić, czy coś zostało stworzone przez sztuczną inteligencję - a będzie to niezwykle trudne - potrzebujemy jakiegokolwiek rozwiązania, dzięki któremu pisarze mogliby budować zaufanie do swojej pracy, dbając o transparentność w kwestii używanych narzędzi. [...] Kiedy inwestujemy swój czas w czytanie książki, wchodzimy w relację z jej autorem, opartą na zaufaniu. To, że niewielka grupa potentatów technologicznych zaprzepaściła prometejskie dzieło i lekką ręką oddała maszynom dar języka, głęboko podważa to historyczne zaufanie. Nie mam wątpliwości, że sztuczna inteligencja wkrótce “napisze’ wspaniałą książkę - ale czy ktokolwiek powinien się tym przejmować? Oklaski będą słabo słyszalne. Podobnie jak nieskazitelny, laboratoryjnie wyhodowany diament, będzie to sztuczny wytwór, trik o niewielkiej wartości, a nie sztuka. W tej nowej rzeczywistości to pisarze będą musieli budować zaufanie do pochodzenia własnych dzieł, otwarcie pokazując, jakim wysiłkiem zostały one przygotowane. Udawanie, że pisanie to zbyt szlachetny fach, by martwić się o takie zaufanie, uważam za naiwność.

Nieco złośliwym komentarzem do tej pełnej emfazy wypowiedzi są z pewnością wyniki badania tego, w jaki sposób ujawnienie korzystania z AI wpływa na postrzeganie jakości tekstu (10.48550/arXiv.2507.01418, 2025). Oto w ramach eksperymentu ludzie i modele językowe oceniali ten sam, napisany przez człowieka artykuł prasowy, przy czym systematycznie zmieniano informacje o autorze oraz oświadczenia dotyczące użycia AI. Wyniki badania pokazały, że zarówno ludzie, jak i modele językowe konsekwentnie obniżały ocenę tekstów, opisanych jako tworzone z użyciem AI.

Autor: redakcja