Tekst wygenerowany przez model językowy, dostrojony na twórczości znanego autora, bardziej podoba się czytelnikom (ekspertom i amatorom) niż proza w jego stylu, napisana przez zawodowych pisarzy. Co więcej, jest niewykrywalny dla detektorów AI, nie powtarza dosłownych schematów z oryginalnych utworów, a jego wytworzenie kosztuje 99.7 proc. mniej niż potencjalne honorarium profesjonalnego pisarza, który miałby przygotować powieść w stylu oryginalnych twórców....

Czytaj dalejW niedawnym badaniu Microsoftu historycy zajęli drugie miejsce na liście kilkudziesięciu zawodów z najwyższym poziomem stosowalności AI (AI applicability score). Tylko praca tłumaczy miała być lepiej dostosowana do możliwości sztucznej inteligencji, a więc potencjalnie łatwiej zastępowalna. Spojrzenie na metody tej analizy sprawia jednak, że nie pozostaje nam nic innego, jak wzruszyć ramionami i zająć się ważniejszymi problemami niż rzekome wypieranie historyków przez AI....

Czytaj dalejSpodziewamy się, że duże modele językowe będą użytecznym wsparciem w tworzeniu opisów zabytków, tłumaczeniu starożytnych tekstów czy rozwijaniu zasobów edukacyjnych. Podjęty niedawno test pięciu modeli open-source na 1066 niepowtarzalnych zadaniach ujawnia jednak poważne ograniczenia. Ponad 65 proc. wygenerowanych odpowiedzi zawiera istotne niezgodności kulturowe (cultural value misalignment)....

Czytaj dalejCzy fikcje w całości generowane przez duże modele językowe mogą nawiązywać do tradycji narodowych i uwzględniać rzeczywistość poszczególnych krajów? Aby to sprawdzić, badacze z Uniwersytetu w Bergen wygenerowali i przeanalizowali niemal 12 tys. opowiadań, przedstawiających historie dla 236 krajów, w tym dla Polski....

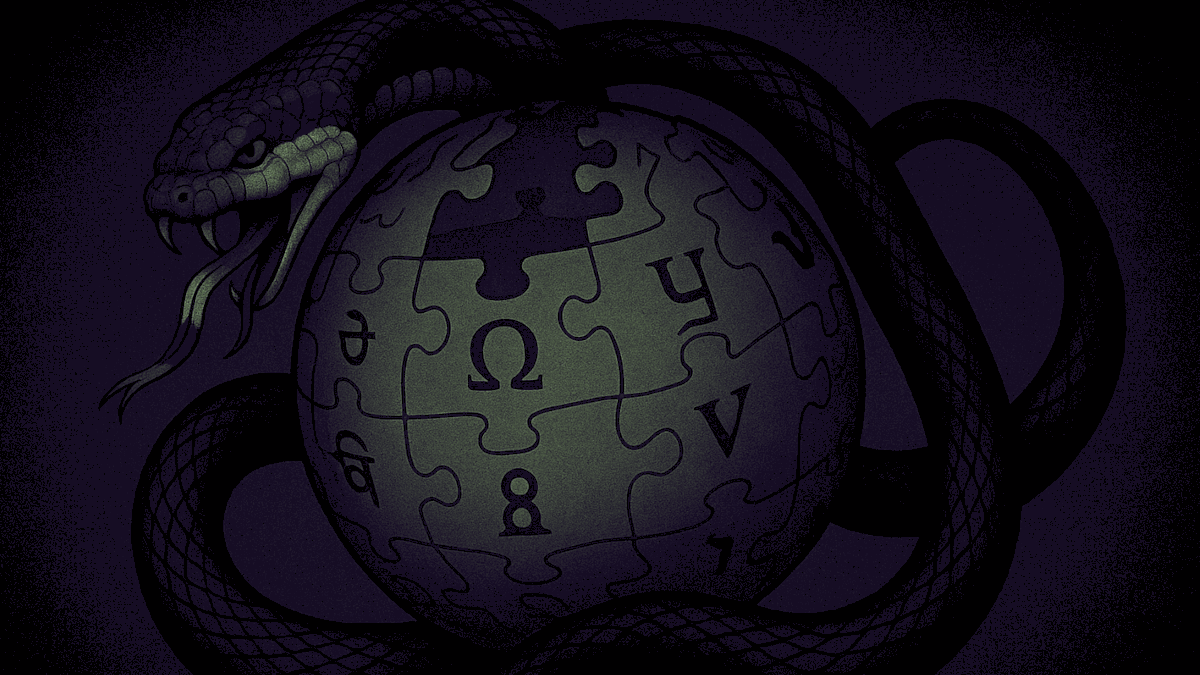

Czytaj dalejOd czerwca 2023 roku działa rosyjski fork Wikipedii. Analiza różnic między treścią rosyjskiej Wikipedii a treścią RuWiki pozwala poznać metody, którymi autorytarne państwo może manipulować największą i dostępną dla wszystkich encyklopedią....

Czytaj dalejDuża część detektorów, mających sprawdzać, czy dany tekst został wygenerowany przez LLM, bazuje na perpleksji. W konsekwencji, jeśli nie mamy naturalnie bogatego słownictwa, albo materia pracy pisemnej wymaga prostego języka, przygotowany przez nas tekst może zostać fałszywie oznaczony. Z tego powodu lepiej ręcznie starać się rozpoznawać generowane teksty. Metody takiego sprawdzania, użyteczne na przykład podczas oceny studenckich prac pisemnych, sugeruje społeczność Wikipedii....

Czytaj dalejMaszynowe generowanie obrazów nie jest środkiem wyrazu artystycznego, ale praktyką zorientowaną na tworzenie wartości dodanej poprzez eksploatację już istniejącej ludzkiej pracy twórczej. Ponieważ ich wytwarzanie odrywa nas od świata i jego materialności, w pewien sposób pozbawia nas człowieczeństwa. Czytamy narzekania na slopy AI, pomieszczone w Social Science Computer Review (2025) i chyba musimy przyznać im rację....

Czytaj dalejWzględnie wysoka jakość dużych modeli językowych w generowaniu logicznego i spójnego tekstu okazuje się argumentem przeciwko wykorzystywaniu ich w pracy nad poezją....

Czytaj dalejCzy tego chcemy, czy nie, maszynowe generowanie tekstu jest już na tym poziomie, że może z powodzeniem imitować literaturę. A skoro tak, to potrzebne są narzędzia, aby taką generatywną literaturę skutecznie oceniać....

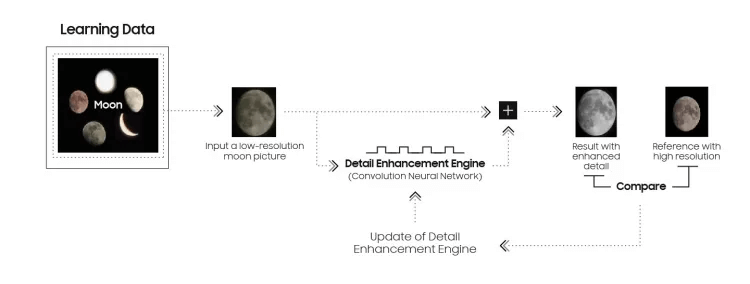

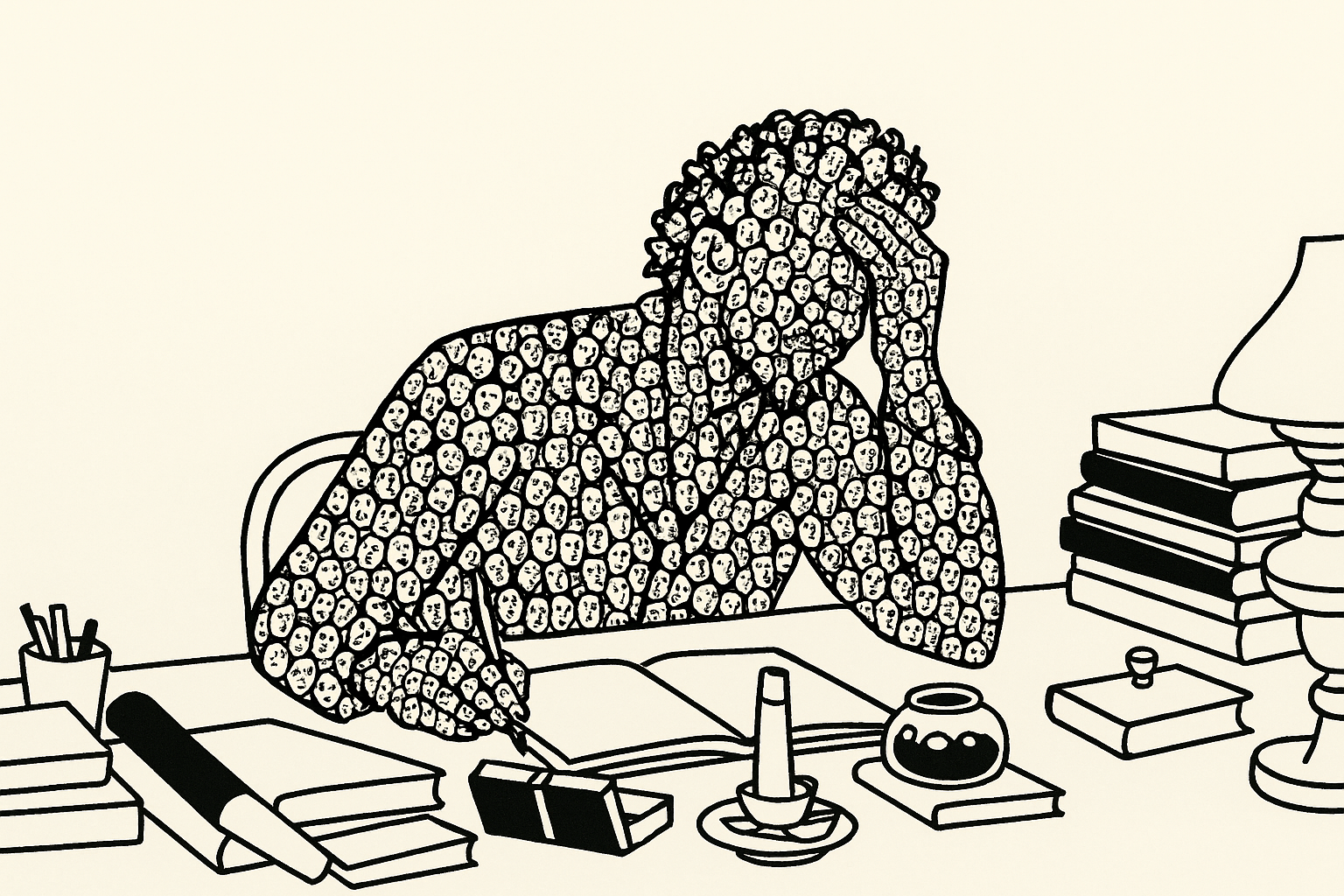

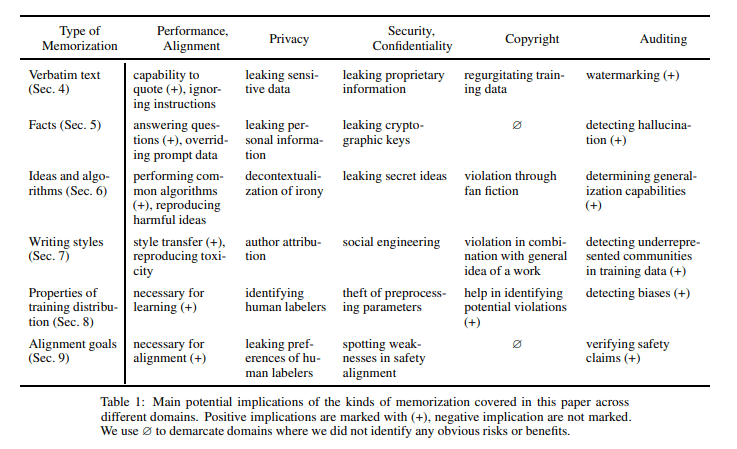

Czytaj dalejMemoryzacja to przechowywanie treści treningowych w wagach modeli językowych. To sytuacja, w której statystyka działająca w modelach odtwarza oryginalne utwory, wykorzystane wcześniej do trenowania. Na przykład Twoje książki i artykuły....

Czytaj dalej