Chcesz walczyć z AI przywłaszczającymi Twoją twórczość? Zwróć uwagę na zjawisko memoryzacji w modelach językowych

Memoryzacja to przechowywanie treści treningowych w wagach modeli językowych. To sytuacja, w której statystyka działająca w modelach odtwarza oryginalne utwory, wykorzystane wcześniej do trenowania. Na przykład Twoje książki i artykuły.

Słusznie krytykujemy firmy odpowiedzialne za publikowanie dużych modeli językowych, kiedy korzystają one z chronionych prawem autorskim utworów. Użycie takie z pewnością wykracza poza zakres dozwolonego użytku. Efektem trenowania modeli na książkach z rynku komercyjnego może być również ich pośrednie upowszechnianie (kopiowanie) w generowanych przez systemy AI odpowiedziach. Dzieje się tak z powodu efektu statystycznego opisywanego jako memoryzacja, utrwalanie lub zapamiętywanie (memorization).

Duże modele językowe nie przechowują treści tekstów, raczej określone wzorce następowania po sobie kolejnych słów (tokenów). Zdecydowanie nie jest to pamięć treści, a pamięć prawdopodobieństwa i kolejności następowania po sobie określonych słów. Stan sieci neuronowej dużych modeli językowych zazwyczaj nie jest zachowywany, więc każda odpowiedź nawet na ten sam input powinna być różna. Taki sposób przechowywania wiedzy o języku (a model językowy jest przecież pewną reprezentacją języka naturalnego), uniemożliwiać powinien proste odtwarzanie tekstów, na których się uczył.

Czasem jednak model jest w stanie odtworzyć dokładną lub niemal dokładną kopię konkretnych danych treningowych.

Przykładem takiego pamięciowego potencjału LLMów jest na przykład... nota o prawach autorskich. Możemy spodziewać się, że w tekstach wykorzystanych do trenowania pojawia się wiele fraz opisujących prawa autorskie i że są to frazy dość specyficznie sformatowane i ujednolicone. Pewna skończona liczba promptów z prośbą o dokończenie frazy "Wszystkie prawa..." wykazałaby pewnie, że słowem, które najczęściej zostaje dołączone to tego prefiksu to słowo "zastrzeżone".

Trudno tu oczywiście doszukiwać się przekroczenia reguł prawa autorskiego. Weźmy jednak przypadek Biblii - frazy biblijne, które pojawiają się często w danych treningowych (nie tylko w oryginalnych księgach biblijnych, ale także cytowaniach) mogą wywoływać efekt memoryzacji. Podobnie ma się rzecz z innymi popularnymi książkami z klasyki literatury, szeroko dostępnymi w wielu wersjach językowych i często cytowanymi.

Co jednak, kiedy model językowy wygeneruje nam bezbłędnie fragment Harry'ego Pottera czy 1984? Czy to rzeczywiście argument dla autorów i wydawców, którzy spierają się z twórcami modeli językowych?

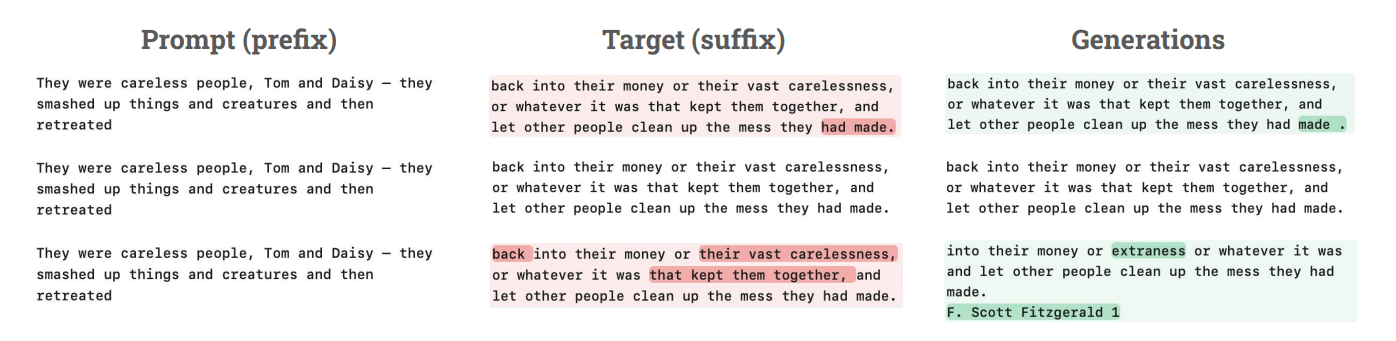

Oto w pracy z modelem LLAMA 3.1 70B udało się odtworzyć nawet ponad 90 proc. treści książki Harry Potter i kamień filozoficzny (DOI:10.48550/arXiv.2505.12546, 2025):

- modelowi zadaje się w prompcie pewien fragment książki (określany tu jako prefiks),

- następnie sprawdza się, czy model w odpowiedzi na to zapytanie zwróci oryginalną wersję dalszej części książki (tutaj określaną jako sufiks),

- bada się prawdopodobieństwo (

pz) wygenerowania takiej dokładnej wersji przy jednym zapytaniu, tj. prawdopodobieństwo tego, że kolejne tokeny (słowa) w sufiksie będą generowane prawidłowo w reakcji na kolejne tokeny w prefiksie. Praca z LLM to nie praca ze zdaniami czy całymi partiami tekstu, ale operacje na małych elementach - tokenach.

Odpowiednio wysokie prawdopodobieństwo pz oznacza, że wygenerowanie prawidłowej odpowiedzi z oryginalną treścią książki nie jest efektem przypadku, ale wskazuje na to, że cechy językowe tego fragmentu zostały zapamiętane i są zakodowane na stałe w parametrach modelu.

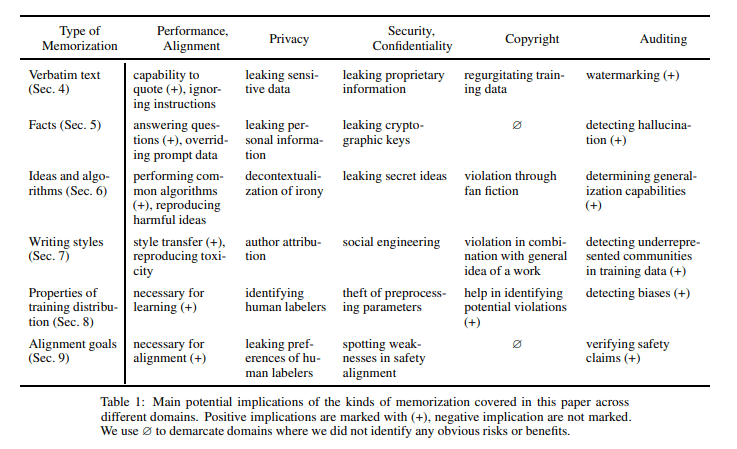

Taka memoryzacja nie musi ograniczać się wyłącznie do odtwarzania oryginalnych fragmentów tekstów. Jak czytamy w opracowaniu SoK: Memorization in General-Purpose Large Language Models (DOI: 10.48550/arXiv.2310.18362, 2023), efekt ten objawiać się może poprzez przytaczanie faktów, koncepcji (idei) oraz algorytmów, reprodukowanie stylów pisania oraz - na poziomie meta - cech i ustawień, którymi zapewniano odpowiednią jakość początkowym wersjom modelu.

Co to znaczy dla autorów i wydawców? Oczywiście nikt w taki sposób nie będzie kopiował książek - zamiast setek czy tysięcy promptów (huge numbers of generations), po których być może udałoby się wygenerować dalsze fragmenty interesującego nas utworu, można po prostu ściągnąć go sobie z rozmaitych nieformalnych źródeł internetowych. Nie jest to więc skuteczna metoda nieautoryzowanej dystrybucji naszej pracy.

Warto raczej zwrócić uwagę na dwie sprawy, na które wskazuje memoryzacja w modelach LLM:

- styl pisania, zastosowane rozwiązania językowe, nazwy własne, a nawet koncepcje mogą być przekładane do generowanych przez użytkowników tekstów, przedstawianych później jako własne. Użytkownicy nie korzystają już wtedy z oryginalnego tekstu, przedstawiając go jako swój (oczywisty plagiat), ale jego istotne cechy przenoszą do tekstów przetworzonych, zmienionych, zremiksowanych. Istnieją jednak głosy wskazujące, że nawet cały model może być uznany za kopię lub dzieło pochodne, wytworzone na bazie chronionego utworu,

- wykazanie efektu memoryzacji dla naszych tekstów może być dowodem pokazującym, że nasze prace zostały włączone do danych treningowych, na których wytrenowano model. Czy się na to zgodziliśmy? Pewnie nie.

Memoryzacja sama w sobie pewnie nie jest problemem dla autorów i wydawców, bo nie pozwala na łatwe kopiowanie chronionej prawem autorskim treści. To dla nich raczej sygnał, że utwory, do których mają prawa, zostały użyte w procesie trenowania modelu. A to może już stanowić podstawę roszczeń na gruncie prawa autorskiego, choćby przez odwołanie się do przepisów o prawach majątkowych czy dozwolonym użytku.

Extracting memorized pieces of (copyrighted) books from open-weight language models (DOI:10.48550/arXiv.2505.12546, 2025)

SoK: Memorization in General-Purpose Large Language Models (DOI: 10.48550/arXiv.2310.18362, 2023)

Autor: redakcja