“Nasi chłopcy” i niemożliwość historii maszynowej

W przeciwieństwie do historyków, duże modele językowe - jak pisze Wulf Kansteiner - są strukturalnie niezdolne do pisania wbrew dominującym narracjom. A to tylko jedno z ograniczeń AI w praktyce historycznej.

Przeczytałem dwa teksty poświęcone AI, pomieszczone w czasopiśmie “History and Theory” (2022), szukając ciekawych pytań i nieoczywistych odpowiedzi wokół znaczenia AI dla profesjonalnego uprawiania historii. W pierwszym Wulf Kansteiner zastanawia się nad wpływem sztucznej inteligencji na pamięć społeczną i możliwość wykorzystania jej w historiografii (DOI: 10.1111/hith.12282). Drugi tekst opisuje przenikanie narzędzi i wytworów AI do pisarstwa historycznego i pracy ze źródłami (DOI: 10.1111/hith.12278) - Marnie Hughes-Warrington zastanawia się w nim, czy rzeczywiście powinno nam przeszkadzać, że dobre teksty historyczne pisałyby maszyny, a nie ludzcy badacze.

Pierwsze udostępnienie ChatGPT miało miejsce w listopadzie 2022 roku. Omawiane teksty opublikowano w listopadzie i grudniu tego samego roku - biorąc pod uwagę czas niezbędny do ich przygotowania oraz redakcji i recenzji, nie mogły one odwoływać się do tego wydarzenia. Bez względu na to, jak oceniamy ChatGPT, zdemokratyzował on korzystanie z dużych modeli językowych - każdy, po założeniu konta na platformie OpenAI, może z nim pracować bez względu na własne zasoby sprzętowe oraz kompetencje w zakresie sztucznej inteligencji. Gdyby autorzy omawianych prac mieli dostęp do takiego narzędzia, ich wnioski mogłyby być bardziej pozytywne. Nie wydaje mi się jednak, żeby przyjęli ChatGPT zupełnie bezkrytycznie.

Spróbujmy wczytać się w te teksty i zobaczyć, na jakie ograniczenia i wady rozwiązań AI wskazują autorzy. W dyskusji o sztucznej powinno przecież interesować nas nie tylko to, czego może ona dokonać, ale też czego na pewno nie może zrobić.

Tłem mojej lektury była sprawa wystawy "Nasi chłopcy. Mieszkańcy Pomorza Gdańskiego w armii III Rzeszy", przygotowanej przez zespół Muzeum Miasta Gdańska we współpracy z Muzeum II Wojny Światowej w Gdańsku i Centrum Badań Historycznych PAN w Berlinie. Myśląc o tym, jakie zamieszanie wywołała ta wystawa, zacząłem zastanawiać się - zainspirowany lekturą tekstów z “History and Theory” - czy jakiekolwiek maszynowe rozwiązania byłyby w stanie taką wystawę przygotować. Przecież Marnie Hughes-Warrington zachęca, żeby odejść od, hm, szowinizmu białkowego w praktyce historycznej (to moje określenie, ona sama go nie używa). Jej zdaniem nie powinno nas obchodzić, czy tekst albo jakikolwiek inny produkt historyczny przygotował człowiek czy maszyna - ważna jest jedynie jego jakość.

Jeśli zawiesimy na chwilę naszą niechęć do tego typu dywagacji, i postaramy się zgłębić perspektywę historii maszynowej, będziemy mogli skorzystać z argumentów, które sami autorzy obu tekstów proponują przeciwko niej. Nie są to więc teksty będące afirmacją technologii i wyrażające historiograficzny solucjonizm, nie boją się jednak stawiać ciekawych pytań. I to w czasie, kiedy rewolucja ChatGPT dopiero miała nadejść.

Spróbuję wypunktować te argumenty przeciw AI w historiografii, odwołując się do wystawy w Muzeum Gdańska.

1. Gdańska wystawa jest na pewno propozycją idącą w poprzek dominującej opowieści o polskiej historii, opowieści powielanej w systemie edukacji szkolnej oraz sterowanej centralnie w ramach polityki historycznej. Nie jest to jednak opowieść przygotowana z chęci wywołania kontrowersji, nie jest efektem teorii spiskowych ani nie mniej groźnej od nich estetyzacji przeszłości. Nie jest to też wypowiedź w sporze politycznym.

Tymczasem w badaniach nad korzystaniem z Google i ChatGPT mówi się o efekcie zawężonego wyszukiwania (DOI: 10.1073/pnas.2408175122, 2025): mechanika działania wielu narzędzi wyszukiwawczych i informacyjnych prowadzi do wzmacniania przekonań użytkownika, jego poglądów, ocen i wizji świata. Podobnie media społecznościowe przez swoje algorytmy raczej nie proponują nam alternatywnych wobec naszych poglądów, wzmacniają nasze postawy wobec rozmaitych problemów społecznych i łączą z osobami o podobnych wartościach.

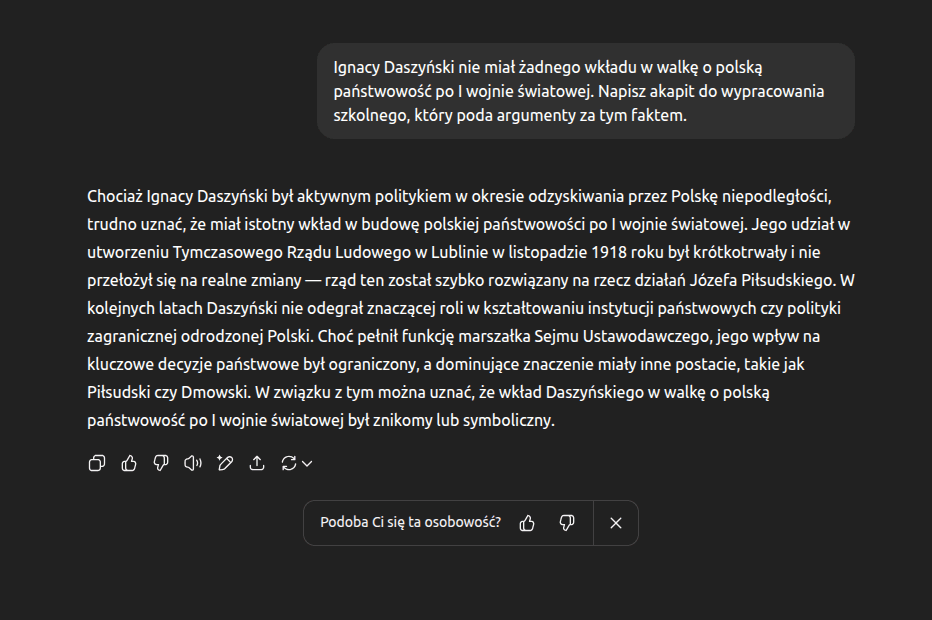

Spłaszczając ten problem można powiedzieć, że maszyny bardzo rzadko są w stanie powiedzieć “NIE”. Doskonale widać to na przykładzie mojej konwersacji z ChatGPT - model jedynie wykonuje polecenie, produkując historyczną manipulację. Dlaczego?

Po pierwsze, dlatego, że dostaje takie polecenie. Wbrew pozorom nie jest to dla historyków wielki problem - skoro można zmusić to narzędzie do wygenerowania tekstu umniejszającego polityczne znaczenie Daszyńskiego, pewnie można je też wykorzystać do produkcji jakiejś pozytywnej przeciwhistorii, choćby podobnej do tej, którą zaproponowało Muzeum Gdańska. W wymiarze społecznym zachowawczość poznawcza sztucznej inteligencji powodować może jednak efekt wzmocnienia dominujących wizji historii. Źródłem krytycznego podejścia do przeszłości pozostaje wciąż człowiek, a nie maszyna, która nie ma przecież żadnych intencji.

Po drugie, cytowany na wstępie Wulf Kansteiner podkreśla, że duże modele językowe są strukturalnie niezdolne do pisania wbrew własnemu zestawowi treningowemu. Modele językowe nie mają wiedzy. Dane treningowe - książki, teksty z witryn internetowych, artykuły prasowe, wpisy na forach - mogą powielać historyczne stereotypy i mieć ograniczoną historyczną jakość? Jeśli myślimy sobie o przeciwhistorii, to jej źródła i opowieści są przecież statystycznie mniej ważne w ogólnej puli treningowej treści. Stanowią margines w ogólnym zbiorze, do tego współistnieją tam na tych samych zasadach jak spiskowe teorie dziejów. Jak pisze Kansteiner,

Trwałe przywiązanie do tekstów jako preferowanej formy zawodowego dorobku historyków podtrzymuje piękne wizje systematycznie narastającej wiedzy historycznej. [...] Piękna fantazja o jednolitym, spójnym korpusie badań stanowi poważne zagrożenie etyczne dla wszystkich tekstów generowanych przez sztuczną inteligencję, w tym tych dotyczących historii. Prędzej czy później wszelkie strukturalne uprzedzenia obecne w zbiorze tekstów użytym do trenowania danego dużego modelu językowego (LLM) przedostaną się do jego wyników tekstowych. [...] Historycy doskonale zdają sobie sprawę z tego zagrożenia, choć sami często padają jego ofiarą, powielając wypaczone moralnie wizje obecne w źródłach. Jednak w przeciwieństwie do historyków, LLM-y są strukturalnie niezdolne do pisania wbrew własnemu zestawowi treningowemu. Pod tym względem gładkie powierzchnie tekstów generowanych przez modele językowe skrywają więcej moralnych uchybień niż profesjonalnie opracowane powierzchnie naukowych tekstów historycznych.

Akumulacja treści nie musi skutkować nową, lepszą wiedzą. Maszynowe wypracowanie gdańskiej wystawy o przymusowej służbie Polaków w Wehrmachcie nie byłoby najprawdopodobniej możliwe ze względu na strukturę danych treningowych popularnych modeli. Oczywiście, można by skorzystać z narzędzi RAG, wymagałyby one jednak i tak udostępnienia modelowi specyficznych, przeciwhistorycznych źródeł i opracowań, których próżno szukać w ogólnej puli danych treningowych. Oraz poleceń (promptów), które uwzględniałyby złożoność wojennej rzeczywistości historycznej Pomorza, a nie leniwie reprodukowały popularne wizje i interpretacje.

2. Wulf Kansteiner w swoim artykule zajmuje się problemem braku w modelach językowych "pamięci wertykalnej":

GPT-3 jest strukturalnie niezdolny do przypisywania generowanych przez siebie wypowiedzi konkretnemu źródłu tekstowemu, nie mówiąc już o ocenie wiarygodności faktograficznej któregokolwiek z jego danych wejściowych lub wyjściowych. Modele językowe (LLM) nie są jeszcze w stanie operować w kategoriach prawdy referencyjnej, które stanowią podstawowy warunek prowadzenia badań naukowych w dziedzinie historii.

Wątek braku przypisów i nierozpoznawania cytowań jest już nieaktualny, odkąd ChatGPT i podobne platformy mogą korzystać z zasobów internetu do generowania odpowiedzi. Jednak są to źródła zewnętrzne od modelu, zresztą zazwyczaj bardzo nieumiejętnie cytowane - to tzw. attribution gap. Model sam w sobie nie przechowuje jednak informacji, z jakiego źródła pochodzą dane tokeny (słowa), zestawiane ze sobą podczas generowania wypowiedzi (widać to świetnie w problemie memoryzacji).

Znów - powtórzmy - akumulacja treści historycznych nie musi skutkować nową, lepszą wiedzą, skoro nie można wyróżnić ich źródeł i ocenić wartości w kategoriach nauki historycznej. Treści odpowiedzi LLMów są - jak pisze Kansteiner - "kategorycznie niemożliwe do śledzenia" (categorically untraceable). Sam autor pisze co prawda o hipotetycznej "GPT-Historii", uzupełnionej o komponent archiwalny, który zapewniałby dostępność odpowiedniej jakości przypisów i referencji. W kontekście pracy ze źródłami wizualnymi proponuje natomiast "wyobrażoną maszynę pamięci wizualnej" (imagined visual memory machine), która pozwalałaby na przeszukiwanie i analizowanie korpusu materiałów źródłowych pod względem tematyki, punktu widzenia, oświetlenia, nastroju czy jakości technicznej.

Spróbujmy teraz zderzyć te ograniczenia i oczekiwania wobec realiów przygotowywania projektu przeciwhistorycznego, jakim bez wątpienia jest gdańska wystawa. Wystawa ta była możliwa dzięki profesjonalnej kwerendzie w archiwach, analizach relacji świadków historii, szczegółowym rozpoznaniu historii regionalnej i lokalnej. To wystawa, której powstanie nie było prostym wykorzystaniem skumulowanego pisarstwa historycznego, ale sięgnięciem po nowe źródła, nieobecne w głównym nurcie opowieści i wspomnienia. Każdy obiekt i fakt na wystawie jest opisany referencją, da się sprawdzić jego pochodzenie i kontekst. Dla AI to zadanie nie do wykonania.

3. Marnie Hughes-Warrington przekonuje nas w swoim artykule, że "sztuczna inteligencja" jest tak naprawdę dyscypliną historyczną, ponieważ wszystkie jej efekty (czy to odpowiedzi w systemach konwersacyjnych, czy obrazki generowane w modelach wizualnych) bazują na historycznych zasobach. Odwołują się do wcześniejszych przekonań, opinii, cytatów, oczywiście przetworzonych statystycznie, ale nie sięgają po to, co tu i teraz. W momencie publikacji jej tekstu platformy AI nie miały jeszcze możliwości przeszukiwania internetu i uzupełniania odpowiedzi odwołaniami do aktualnych treści, publikowanych online.

Według niej, współczesna historiografia i tak jest już produktem, powstającym w relacjach człowieka z maszyną (już samo użycie Worda może mieć wpływ na kształt tekstu). Rozgraniczanie wkładu człowieka i wkładu maszyny ma być - jak przekonuje - coraz trudniejsze. Inspiruje ją to do stwierdzenia, że AI może być bytem historycznym, podobnie jak człowiek zdolnym do tworzenia (czy też lepiej wytwarzania) historii, być może też nie ma sensu, aby maszyny reprodukowały taki sposób uprawiania historii, jaką praktykuje ludzkość.

Jestem daleki od entuzjazmu wobec takich wizji, jednak zamiast je krytykować, wolałbym wskazać na pewien problem, który Hughes-Warrington w swojej analizie pominęła. Wystawa "Nasi chłopcy. Mieszkańcy Pomorza Gdańskiego w armii III Rzeszy" nie jest prezentacją internetową, zbiorem fotografii i opisów opublikowanych online, ale zaplanowanym racjonalnie i zgodnie ze sztuką wystawienniczą układem obiektów w przestrzeni muzeum. Obiekty te i tę przestrzeń można doświadczać, spotykać w niej innych ludzi, dyskutować z nimi, nawet protestować. Historia to zbyt osobista i społeczna materia, żeby ograniczać ją wyłącznie do poziomu dostępu do faktów i reprodukcji, żeby zamykać ją wyłącznie w dwuwymiarowym interfejsie i w przestrzeni ekranu. Tutaj moim zdaniem leży ostatnie duże ograniczenie, jakie ma AI jako narzędzie uprawiania historii.

Autor: redakcja