The Common Pile - wolne licencje w trenowaniu LLM

Rozwój sztucznej inteligencji nie powinien podważać praw twórców i twórczyń oraz skutkować wywłaszczaniem ich z autorskich praw majątkowych. Oto udostępniony został nowy zestaw danych językowych The Common Pile v0.1, bazujący wyłącznie na treściach dostępnych w domenie publicznej i na wolnych licencjach.

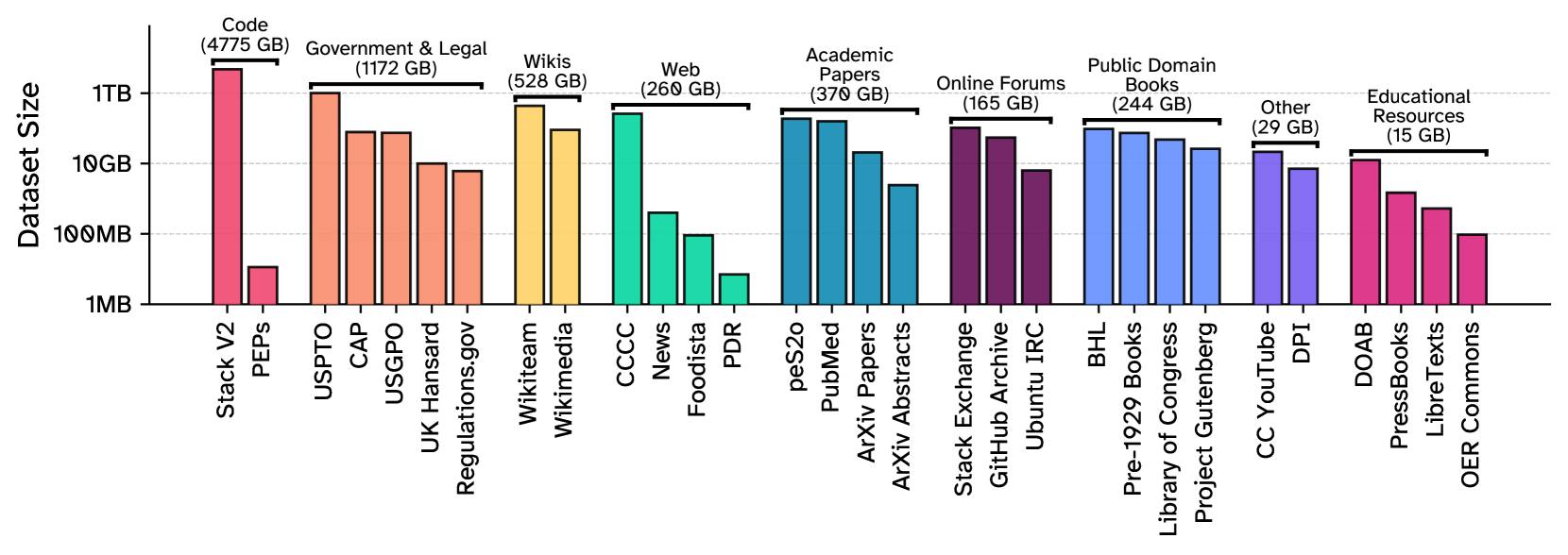

Zobaczmy, jakie treści znajdują się w tym korpusie o objętości około 8TB:

Teksty naukowe – wśród nich znajdują się publikacje udostępnione na wolnych licencjach oraz streszczenia (abstrakty) artykułów objętych pełnym zastrzeżeniem praw. Abstrakty prac deponowanych w repozytorium ArXiv są dostępne na licencji CC0, co umożliwia ich swobodne wykorzystanie, nawet jeśli cały artykuł jest wciąż restrykcyjnie chroniony. Choć abstrakty to jedynie fragmenty pełnych tekstów, ich wartość nie jest pomijalna – w końcu modele językowe nie są uczone wiedzy, ale zależności statystycznych między słowami.

Fora dyskusyjne i społeczności – źródła takie jak zarchiwizowane zrzuty ze StackExchange (udostępniane przez samą platformę w serwisie Archive.org), komentarze i opisy problemów na GitHubie, czy zapisy rozmów z oficjalnego kanału IRC społeczności Ubuntu, stanowią ważne źródło relacji w języku specjalistycznym.

Teksty prawne i dokumenty publiczne – w przypadku USA wiele materiałów wytworzonych przez instytucje publiczne i urzędy federalne znajduje się w domenie publicznej. W innym przypadku korzysta się z dokumentów dostępnych na wolnej licencji (np. wytwarzanych przez urzędy brytyjskie).

Publiczne zbiory danych – zestawy danych udostępniane przez instytucje naukowe czy wydawców, opublikowane na licencjach pozwalających na ponowne użycie, są powszechnie stosowane do tzw. fine-tuningu modeli.

Książki w domenie publicznej – zasoby Internet Archive, Projektu Gutenberg czy Biblioteki Kongresu.

Otwarte zasoby edukacyjne – materiały dydaktyczne i szkoleniowe udostępniane na wolnych licencjach do swobodnego przetwarzania.

Wikipedia – standardowy element wielu korpusów językowych ze względu na zróżnicowanie treści oraz brak ograniczeń prawnoautorskich.

Oprogramowanie open source (FOSS) – m.in. kody źródłowe gromadzone przez fundację Software Heritage.

Transkrypcje nagrań wideo „speech-heavy” z YouTube – oznaczonych licencją CC BY.

Common Crawl – podobnie jak Wikipedia, standardowy dziś element korpusów językowych. Zbiór treści pozyskanych bezpośrednio z witryn internetowych. Tym razem jednak użyte zostały wyłącznie te treści, które wyraźnie oznaczono jako dostępne na wolnych licencjach.

Artykuł opisujący ten zestaw (DOI:10.48550/arXiv.2506.05209, 2025), zwraca przy okazji uwagę na ciekawe, ale negatywne zjawisko. Tak jak można "prać pieniądze", można też uprawiać "license laundering", czyli chronione i zamknięte treści pozyskiwać i przetwarzać do zestawów danych, oznaczając je jako wolne, nie mając też do takiego oznaczania żadnych uprawnień. Tymczasem twórcy zbioru Common Pile przekonują, że odrzucali wszystkie dostępne treści, co do których nie mieli pewności, że są prawidłowo oznaczone jako wolne.

W artykule czytamy też, że

wiele korpusów treningowych jest udostępnianych na otwartych licencjach, jednak licencje te niekoniecznie są zgodne ze statusem licencyjnym poszczególnych dokumentów wchodzących w ich skład.

Autorzy omawianego zestawu danych przekonują o "rosnącym rozdźwięku między twórcami dużych modeli językowych (LLM) a autorami treści. Uważamy, że naturalnym pierwszym krokiem w kierunku rozwiązania tego napięcia jest postawienie pytania: czy możliwe jest trenowanie wydajnych modeli językowych wyłącznie przy użyciu tekstów znajdujących się w domenie publicznej lub objętych otwartymi licencjami?".

Autor: redakcja